(文|刘心月 编辑| 信息 审核|邓昊)近日,第12届国际学习表征会议ICLR(International Conference on Learning Representations)录用了我校信息学院陈洪教授研究组在机器学习泛化理论领域的研究成果。该研究论文以“General Stability Analysis for Zeroth-Order Optimization Algorithms”为题,系统分析了几类零阶随机算法的稳定性与泛化性。ICLR会议由图灵奖获得者Yoshua Bengio和Yann LeCun牵头创办,是中国人工智能学会推荐A类学术会议。

机器学习中一些学习范式(如对抗学习、超参调优、预训练语言模型)对应优化问题往往难以直接计算其对应损失函数的梯度,仅能获得模型预测的误差值,这类问题通常被称为黑盒优化问题。近年来,黑盒优化问题的计算策略(如基于采样的梯度逼近方法)及其统计性质引起人工智能领域广泛关注,依托数学理论基础,零阶优化方法成为解决黑盒优化问题的主要路径之一,其能有效的减轻对直接计算梯度的依赖。

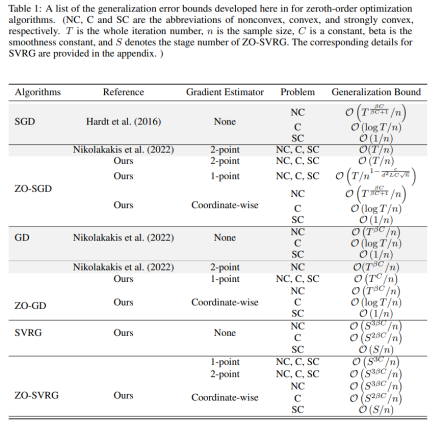

目前,零阶优化算法的计算收敛性已有较广泛研究,然而统计泛化性的分析还相对欠缺。该研究基于算法稳定性与泛化性的内在理论关联,较系统地探讨了零阶优化算法的泛化性能。具体来说,突破已有高斯分布两点估计器的局限,提出了适用于凸、强凸和非凸条件的稳定性分析框架,建立了零阶随机梯度下降(ZO-SGD)、零阶全梯度下降(ZO-GD)和零阶随机方差缩减(ZO-SVRG)等零阶优化算法的泛化误差上界。相关具体分析结果如下表所示:

我校信息学院2022级应用数学方向硕士研究生刘心月为论文第一作者,陈洪教授和MBZUAI顾彬教授为共同通讯作者,MBZUAI张华林博士参与论文研究工作。该研究获国家自然科学基金面上项目等资助。近两年陈洪教授研究组在随机算法的稳定性与泛化性领域进行了积极探索,在CCF A类人工智能国际会议AAAI-2023、NeurIPS-2023、AAAI-2024发表系列研究成果,本项工作是前期学习理论研究在黑盒优化领域的拓展。另外,研究组分别与西安交通大学、南方科技大学等相关课题组合作的机器学习理论研究成果也被本届ICLR录用。